BLOGブログ

【速報レポート#2】META CONNECT 2023 DAY 2 | Meta Quest 3 やMeta AIなどに詰まった技術が熱く語られる!

Meta Quest 3 に積み込まれた技術と情熱、Meta AI開発者の熱いパッションとこだわり・・・開発者向けのディープなお話が繰り広げられるDAY 2

その模様を速報でお届けします・・・!

皆さんこんにちは!株式会社ビーライズ 企画開発部の小笠原です。

いよいよメタコネクトも最終日になりました!

この記事は、 2023年9月28日 日本時間午前2時 Meta(旧: Facebook) が主催するイベント「META CONNECT 2023」にオンライン参戦した模様をお届けするレポートです!

DAY1速報レポートはこちらをご覧ください。

(引用:Meta Connect: Keynote and Developer State of the Union)

https://www.facebook.com/MetaforDevelopers/videos/276458118678817

目次

Day 2で語られたこと

前回は一般やビジネス向けに製品・サービスの紹介が主でしたが、今回は前回発表された製品・サービスのより細かな技術仕様についてや、それらを使って新しいソフトウェアを制作する開発者にとってワクワクするようなトピックが語られました。マーク・ザッカーバーグはこのDay 2には現れず、基本的にはMeta社内のエンジニアやパートナーシップを結んでいる会社をゲストに迎えて、それぞれのプレゼンテーションが語られました。

今回この記事でご紹介するのは、以下の通りです!

- Meta Quest 3開発者が語る「ここがすごいよメタクエ3」

- UnityやUnreal EngineでのMR開発を手軽にするツールを公開

- METAのAI開発の底力

Meta Quest 3 開発者が語る「ここがすごいよメタクエ3」

MetaのデベロッパーリレーションズエンジニアのAR SCHLEICHER氏が登壇し、メタクエスト3の技術革新について多くのことが語られました。

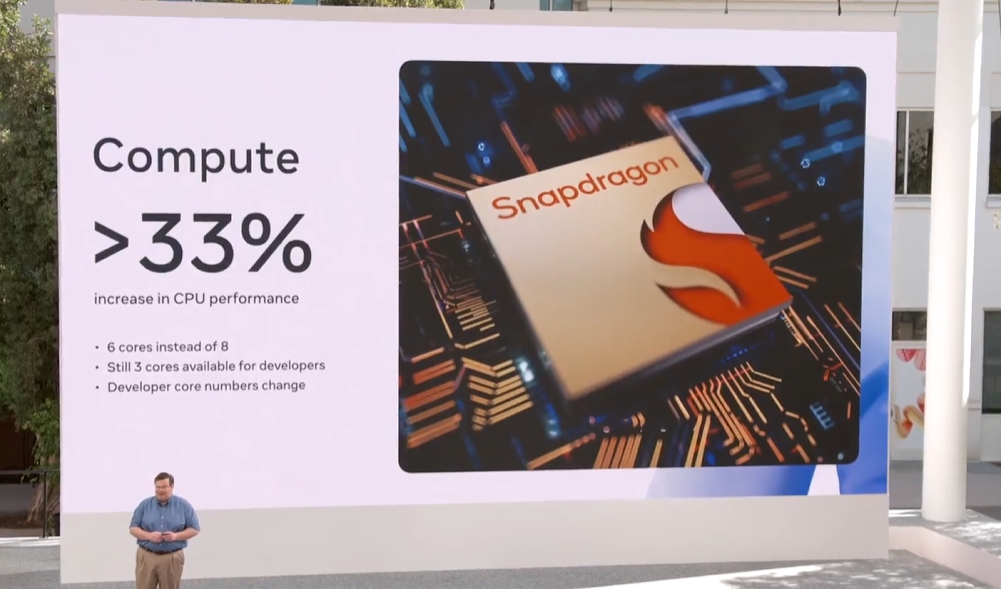

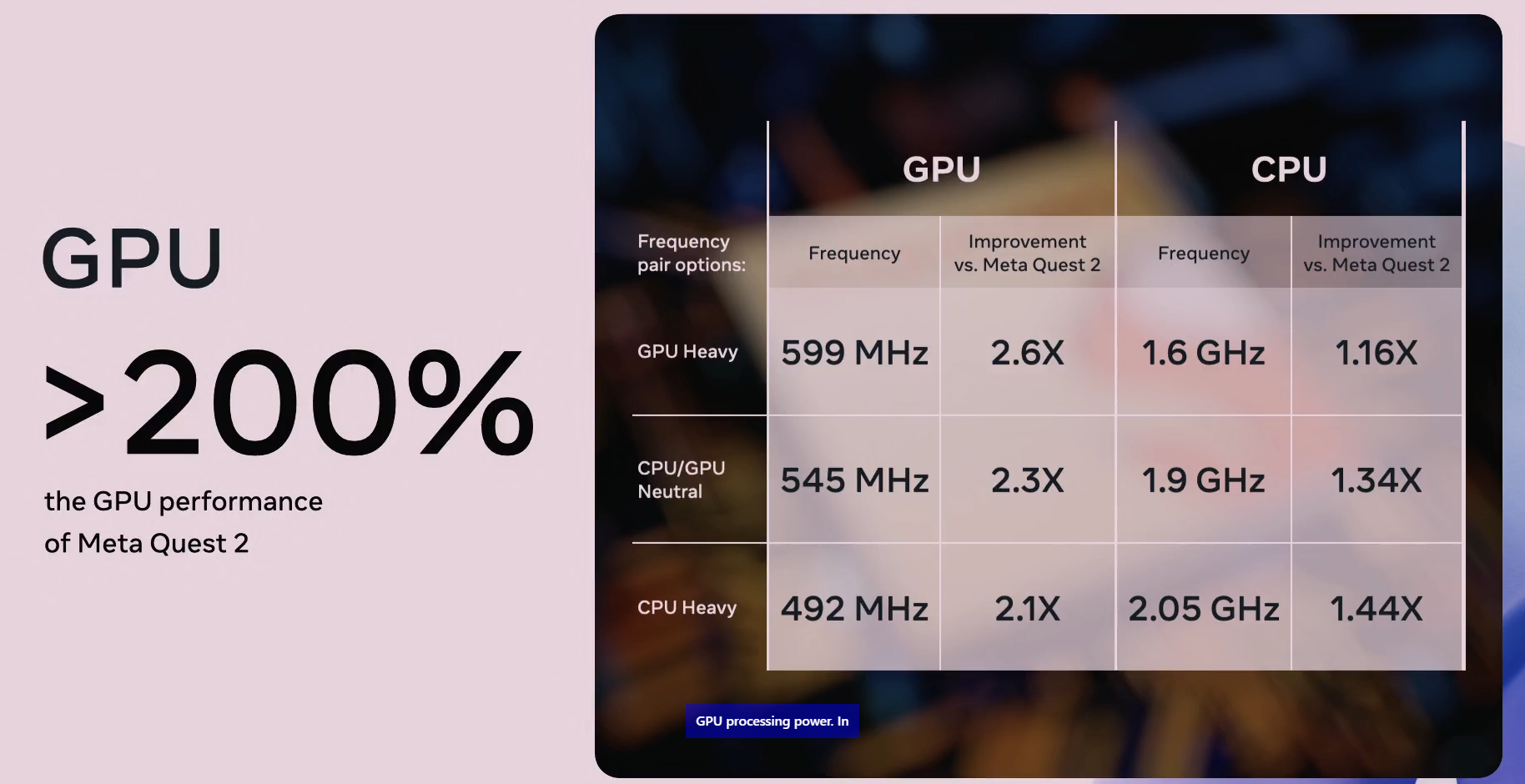

Meta Quest 3はVRとMRの切り替えが瞬時に可能という分、要求されるスペックも上がります。

その要求にともない、CPUやGPUの性能が格段に上がっていることが示唆されました。

よりクリアに、没入感をもたせる工夫として

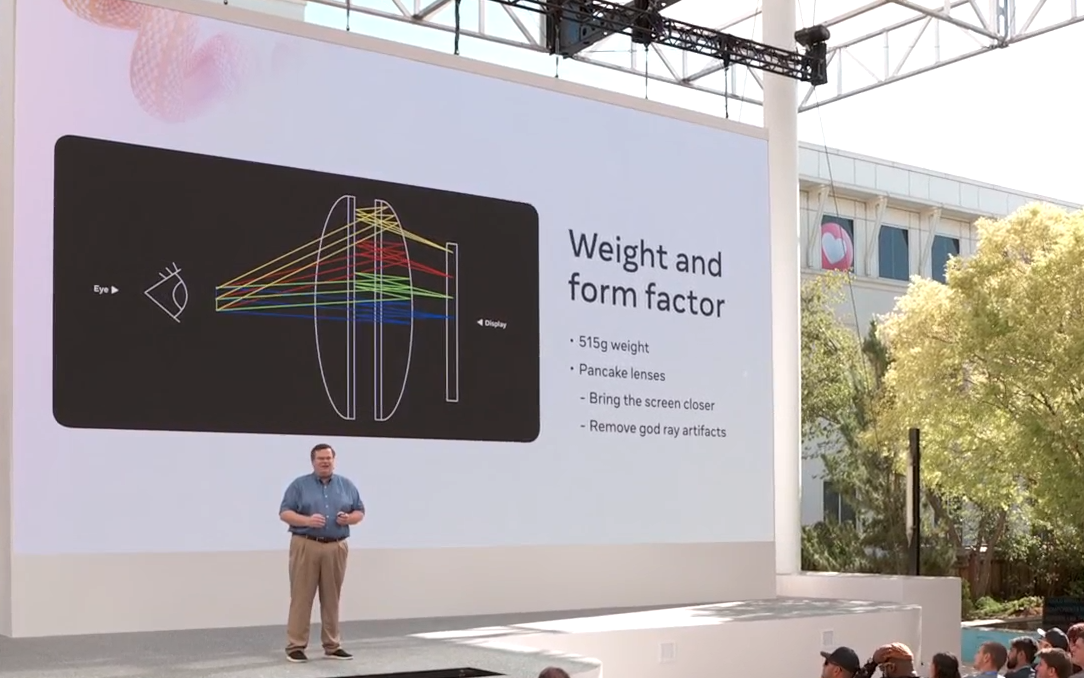

ヘッドセットのディスプレイ映像をパンケーキ光学系のレンズで拡大することにより、システム解像度がMeta Quest 2より20%向上しました。

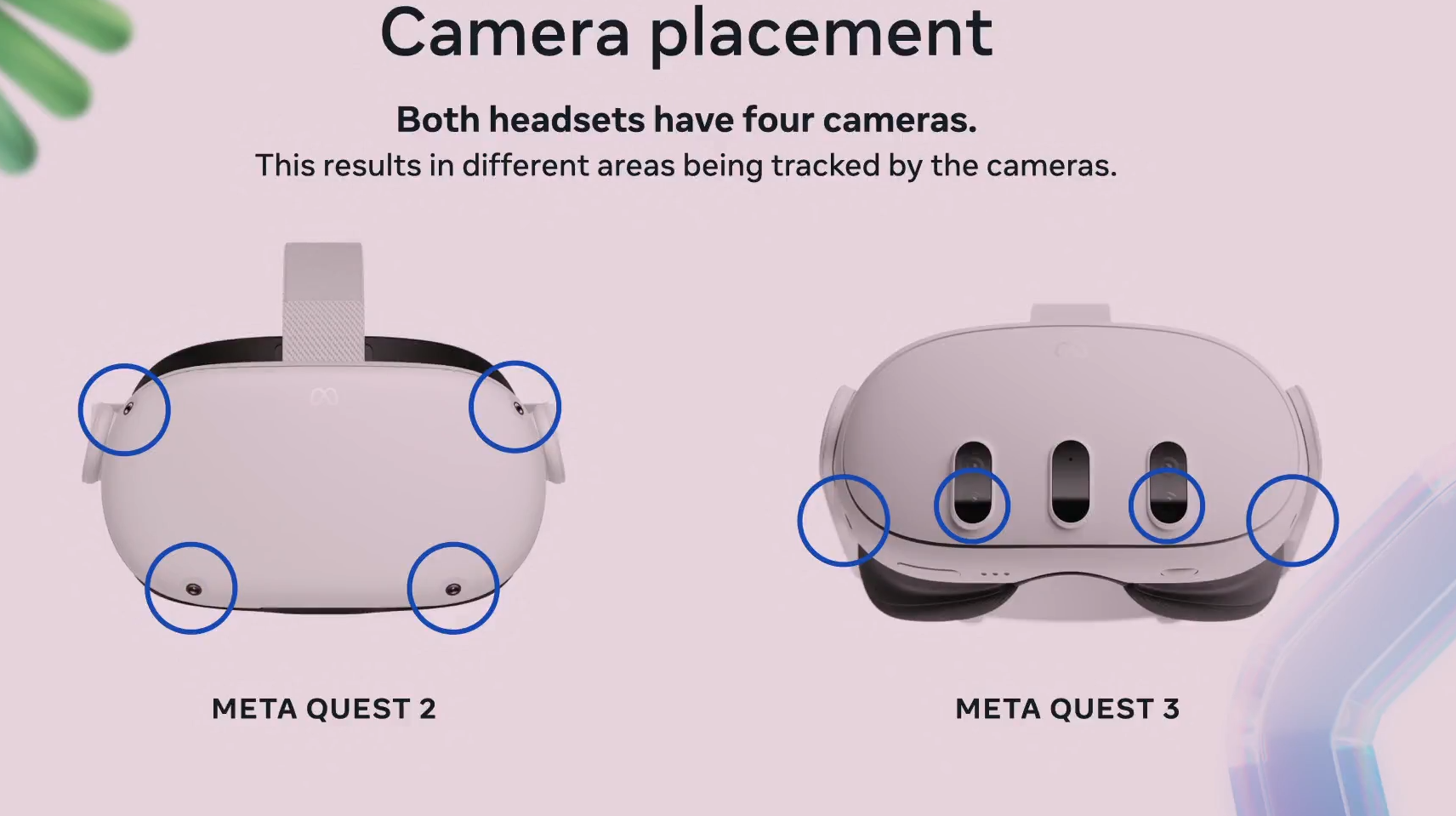

この点は最高の品質ではありませんが、MRとVRを両方体験するために必要な要件をクリアしたようです。 さらにカメラの位置をすべて下部にもっていくというアイデアを採用し、頭より下に移る手やオブジェクトの認識をより正確にするように振り切りました

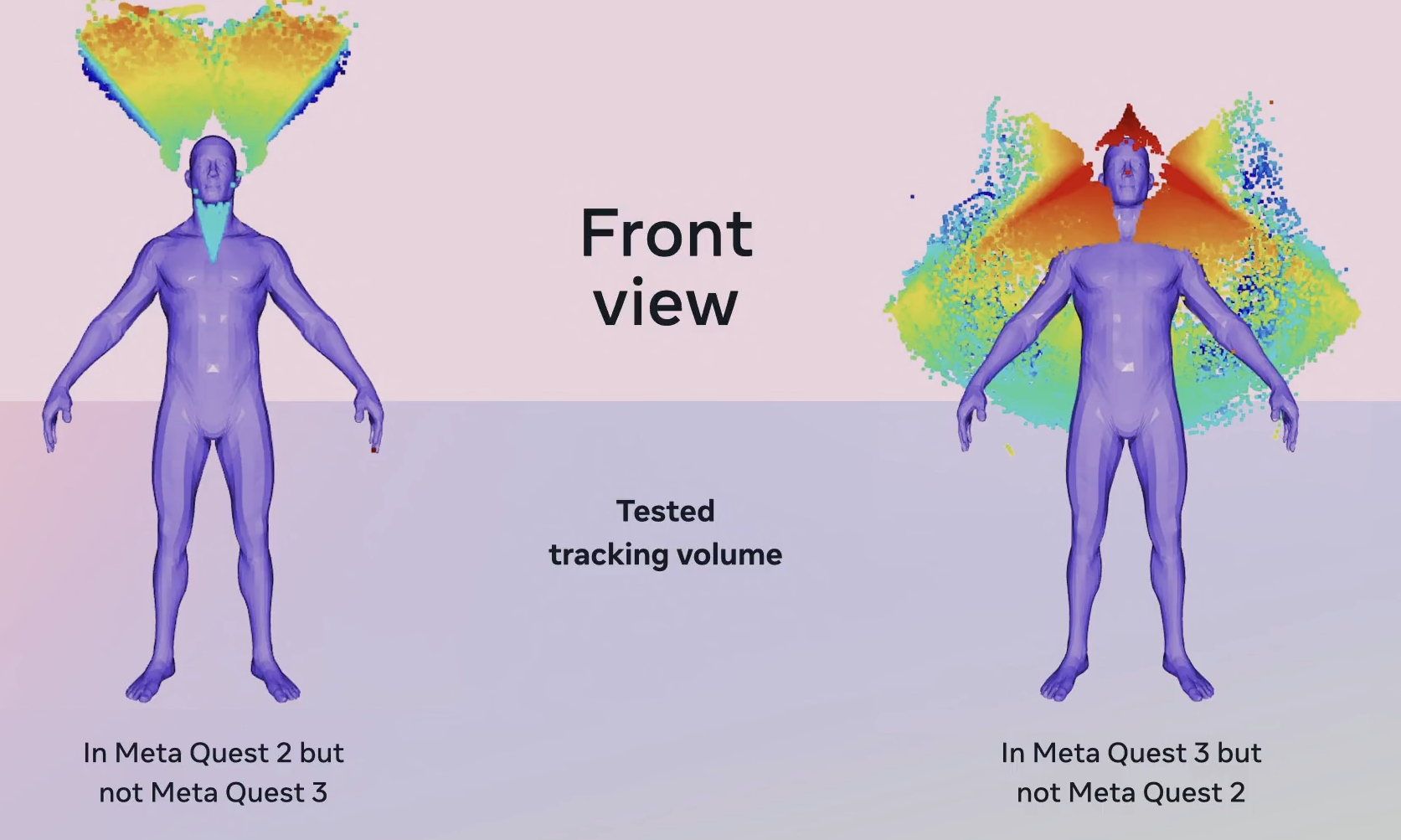

さらにカメラの位置をすべて下部にもっていくというアイデアを採用し、頭より下に移る手やオブジェクトの認識をより正確にするように振り切りました この図でもわかる通り、Meta Quest 2では上部の認識率が高かったのに対し、Meta Quest 3 では上部以外をまんべんなくカバーしているように思えますよね。

この図でもわかる通り、Meta Quest 2では上部の認識率が高かったのに対し、Meta Quest 3 では上部以外をまんべんなくカバーしているように思えますよね。

では上はどうするのか?という問い対しては、今後のアップデートでAIによるトラッキングの精度を上げる開発をしているので、もう少し待っててね、とのことでした!

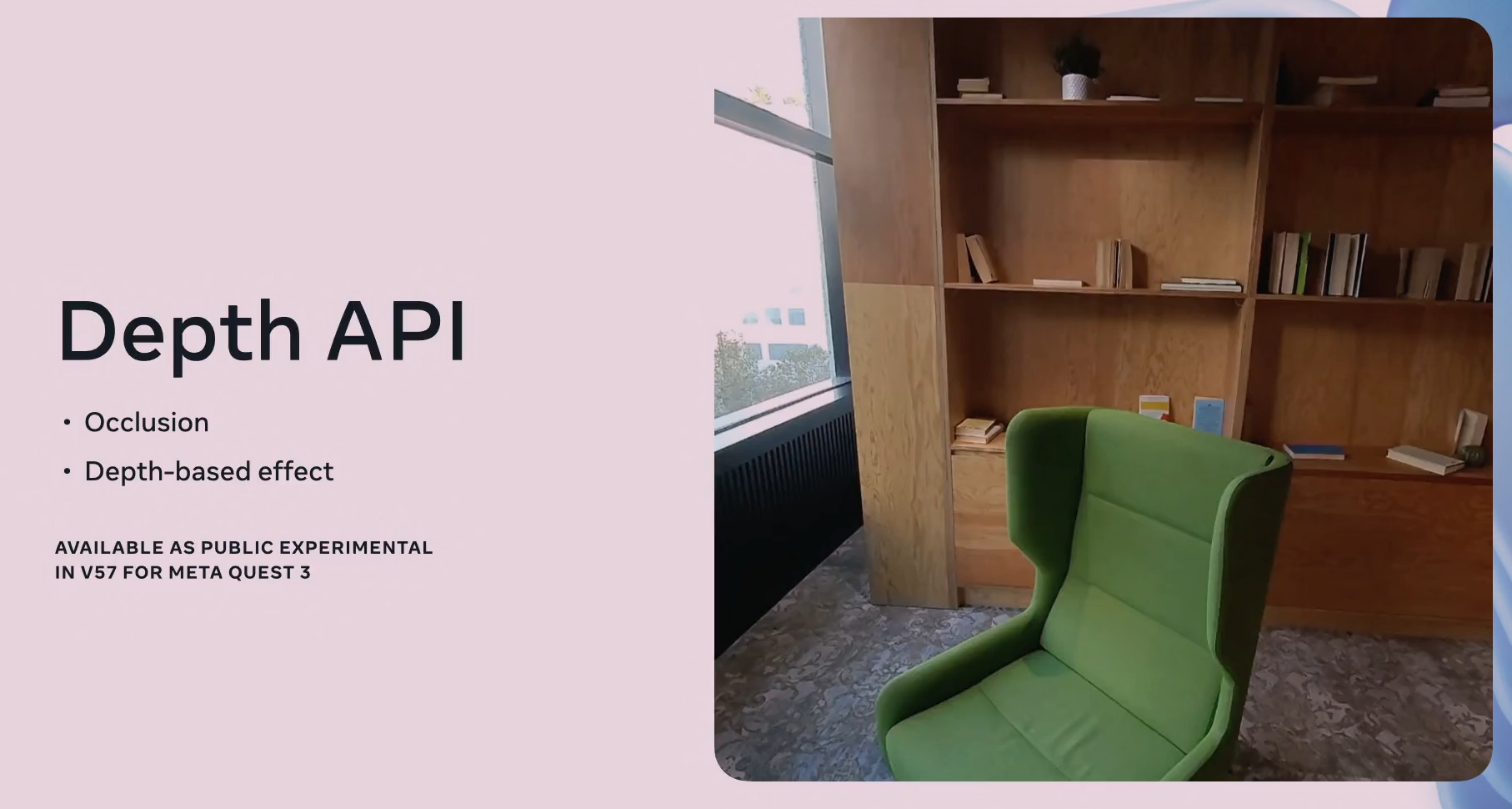

この下部の認識率を上昇させたことにより、空間把握の向上、オクルージョンをリアルタイムで反映させることが可能に!

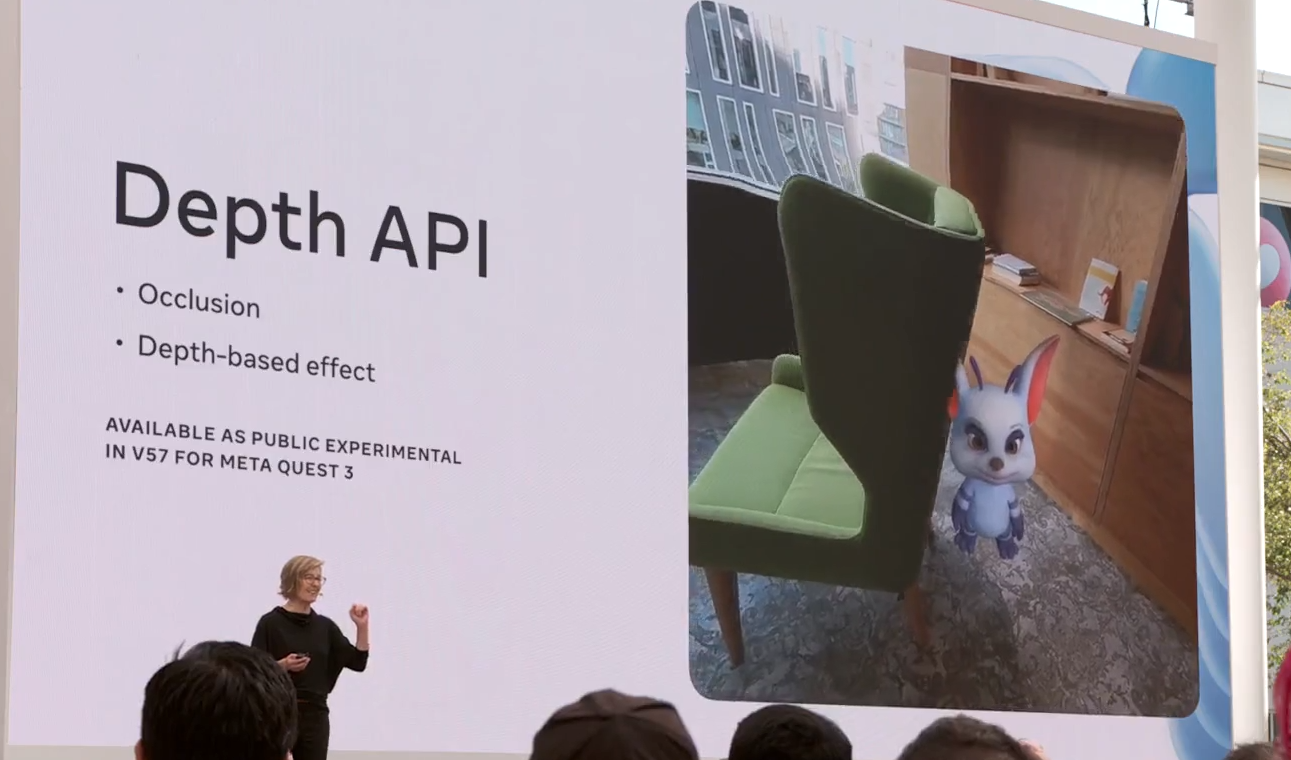

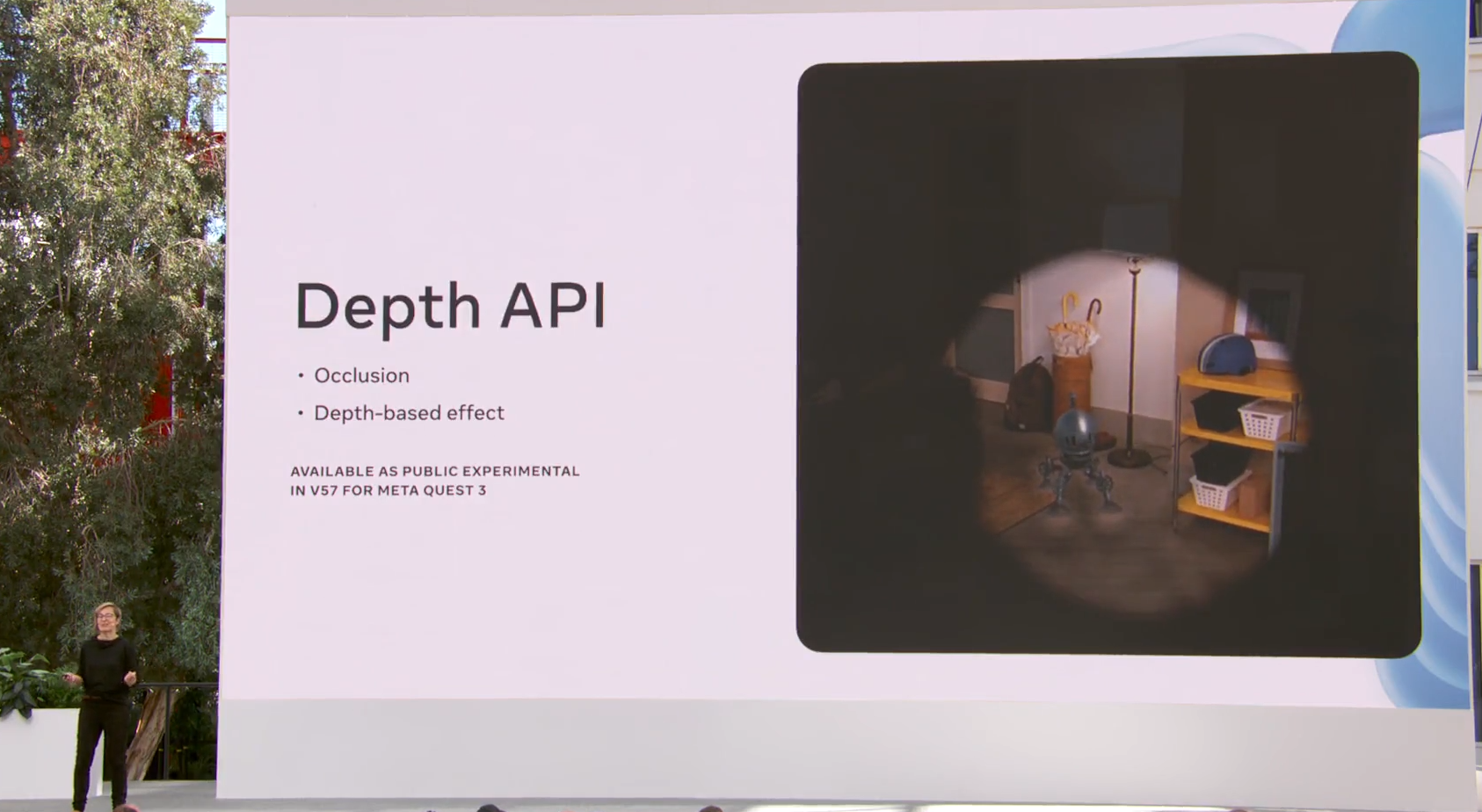

その椅子の向こうには・・・Occlusion(オクルージョン)

今回のメタクエストに搭載されている二つのツール、シーンメッシュ(Scene Mesh)とデプスAPI(DepthAPI)の力を合体させることによって

“壁の向こう側にオブジェクトを置く”ことが可能になりました!

簡単にそのプロセスをご紹介すると、メタクエスト3に搭載されたカメラがその空間をスキャンします。

スキャンしたデータから床やイス、机など、様々な物と物を分けて、一つ一つにメッシュをつけていきます。このメッシュは、”モノをモノとして認識する”ことができるとイメージするとわかりやすいかもしれません。

そして部屋全体を一つのシーンメッシュとして認識した後、Depth APIによって奥行きを与えます。

イスの後ろにはウサギが隠れていました!

スキャンした空間は一つの3D空間としてデータになっているに加え、パススルーで観ている現実世界はすべてカメラ越しの映像なので、現実世界なのにこんなこともできちゃいます!

これはもちろん実際の懐中電灯で照らしているわけではなく、バーチャルのエフェクトなのですが、今までにはない空間演出の創り方ができますね!

UnityやUnreal EngineでのMR開発を手軽にするツールを公開

Building blocks for Unity

Mixed Realityの開発はこれまでとても難しいもので参入が難しかったのですが、MetaはMRの開発を活発にさせるため様々なツールをアナウンスしました。

Building blocks for Unityを使えば、パススルーやカメラリグの設定などの小難しいものをドラッグ&ドロップで自分のUnityシーンに追加することができます。10月から公開される予定だそうです。

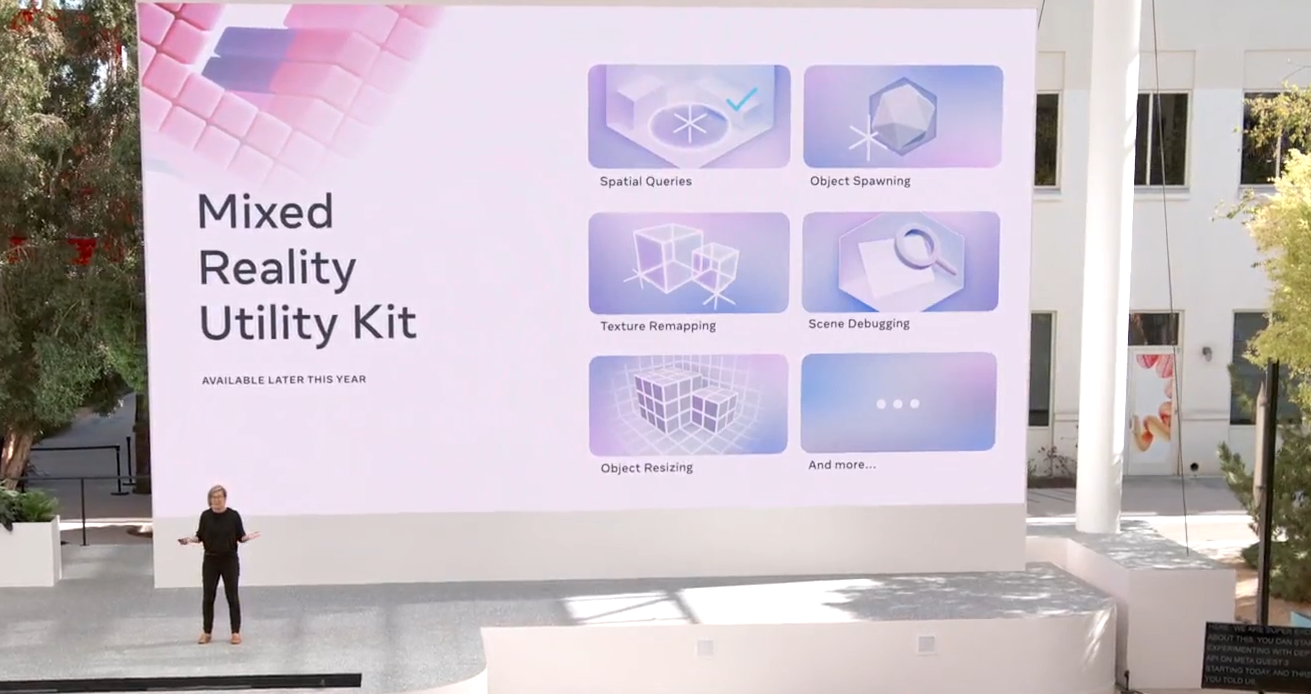

Mixed Reality Utility Kit

ユーザーのスタートポイントの設定から、空間に合わせたオブジェクトのリサイズ機能、テクスチャのリマッピングなど、1からつくっていたらとてつもない機能を簡単にプロジェクトに導入できるユーティリティキットの配布がアナウンスされました!UnityとUnreal Engineで使えるようになり、年内公開予定とのことです。

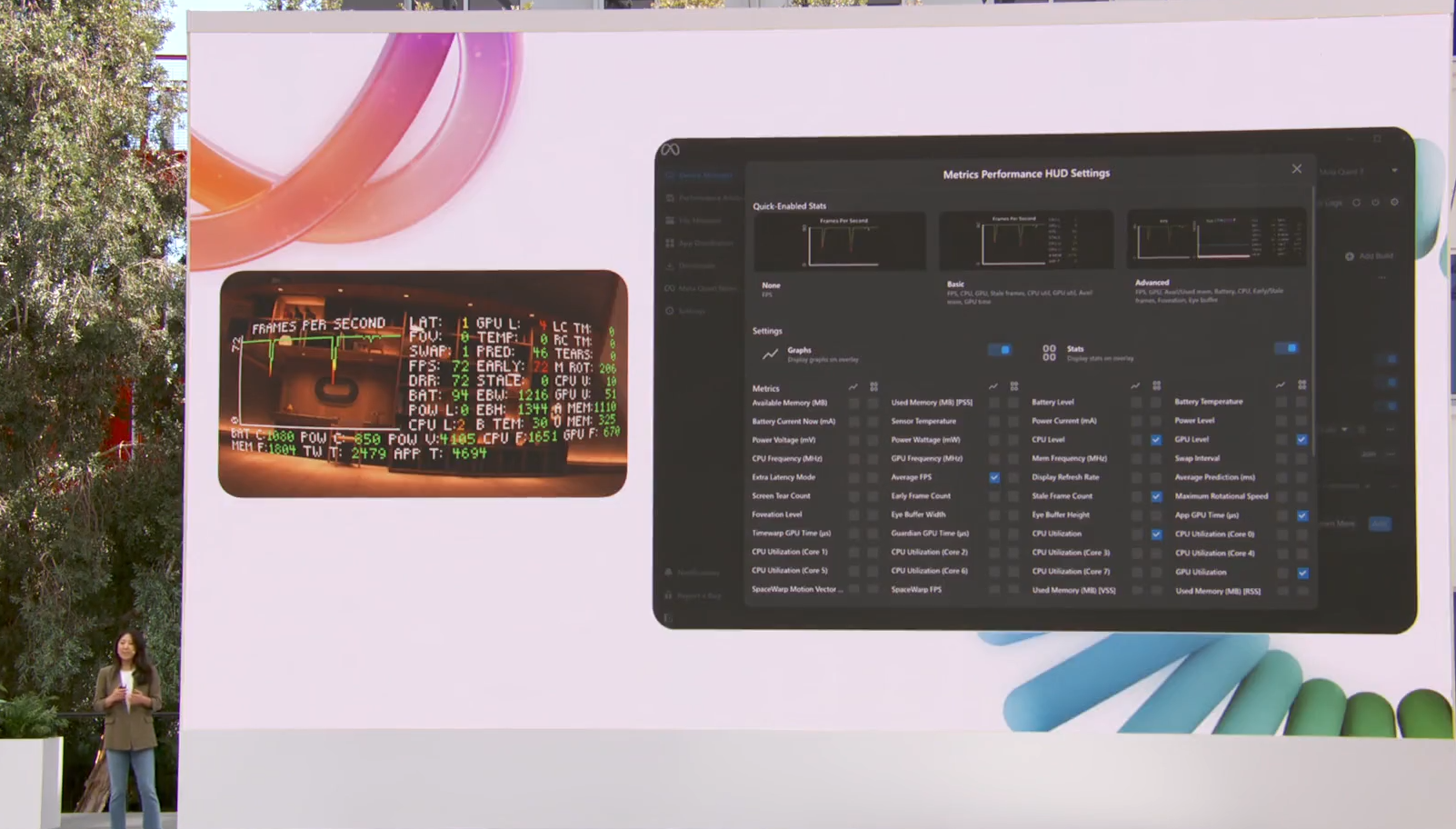

Meta Quest Developer Hub

MQDH(Meta Quest Developer Hub)では、メタクエスト上のMR(/VR)の開発をより効率よく、チームでの開発を円滑にするための開発ハブを発表しました。

開発中のシーンをプレイして、その様子を瞬時に撮影して共有することができたり、プレイ中のCPUやメモリの負荷状況等もリアルタイムでモニタリングすることができたりもします。

他にも、デモ版の公開を「リリースURL機能」で、アップしたYoutube動画を管理するようにプロジェクトを限定/一般公開等を自由に操作することができます。

さらに数クリックでビルドデータを更新することもできたりと、開発の効率化を図る機能が盛りだくさんです。これは是非とも触ってみたい!

Meta XR Simulator(for MQDH)

弊社でもよく見かけるのですが、エンジニアが何度もヘッドセットをかけてプレイテストを行い、日々微調整を行っています。

ちょっと調整するたびにヘッドセットをつける必要はなくなるかもしれません。

キーボード、マウス、Xboxコントローラーを使ってコントローラーを仮操作し、ビルドした環境でシミュレーションを行うことができます。

しかも数クリックでマルチプレイヤーにも対応。な…なんだってー!?

MRの開発環境がものすごいスピードで整備されているのがお分かりいただけるでしょうか。

Metaが掲げているのが、「VRゴーグルをかけて遊ぶのが当たり前の世界」なのではなく

「生活空間とバーチャルが融和し、バーチャル・コンテンツがネイティブで”触れられる”ことが当たり前の世界」を目指しているのだと私は思います。

だからこそ、MRの技術開発をここまで押し上げ、レベルアップ図りながら世界中のエンジニア/クリエイターにも共有している。

それは登壇者のパッションからも伝わってきます。皆さん本当に楽しそうに話していました。

MetaのAI開発の底力

Metaのもう一つのダークホース・コンテンツ、Meta AIの技術者たちによるプレゼンテーションも大変魅力的なものでした。

新しいモデル・進化した対話能力

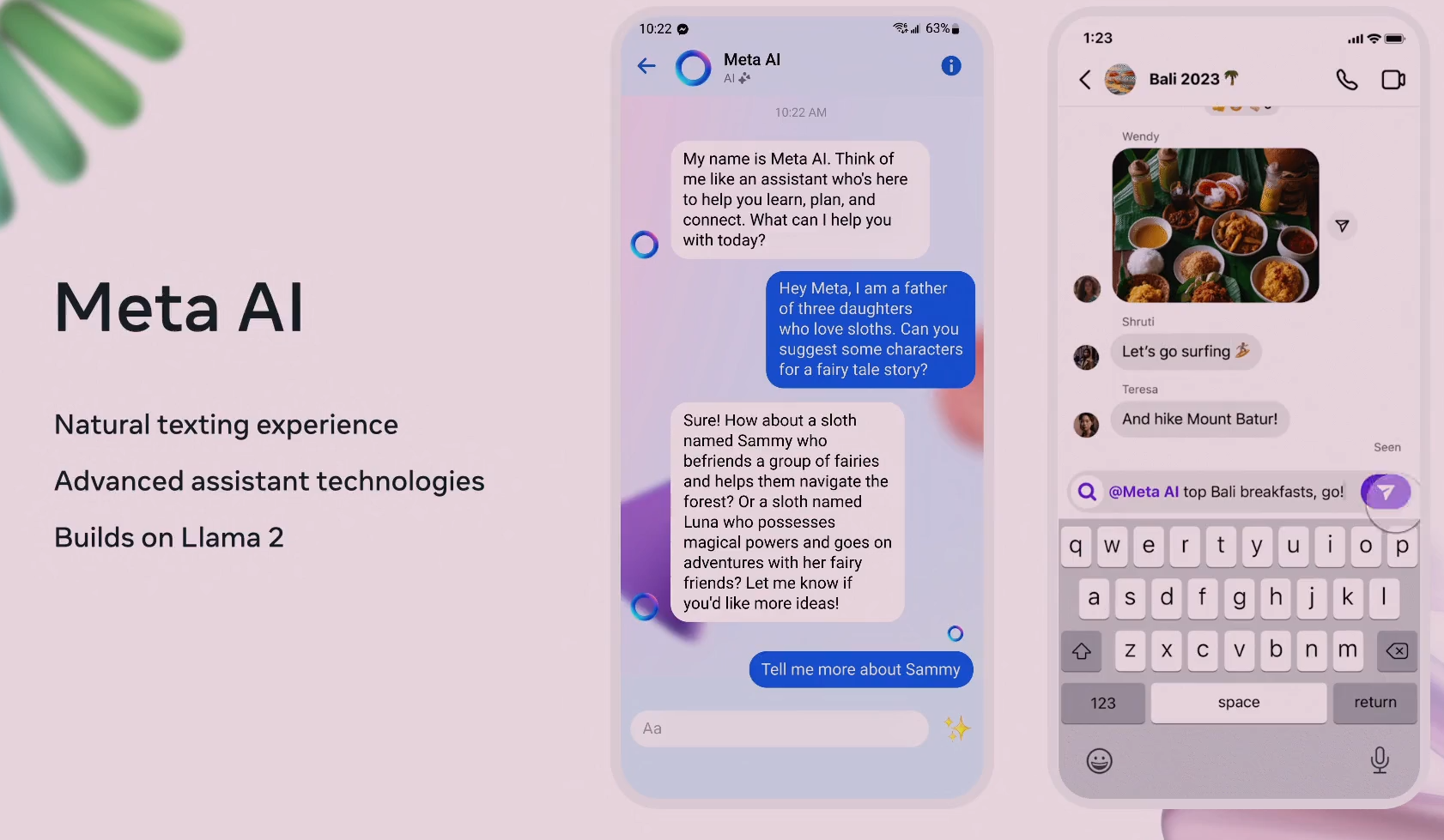

次世代の大規模言語生成モデルLlama2をベースにしたMeta AI。彼らが徹底的にこだわったのは、「ナチュラルな対話」と「幻想のない回答」でした。

上の写真の右側のように、グループチャットの中にMeta AIが参加していて、そのテキストの文脈に沿って”ナチュラルに”返していく。まるで人間のように。

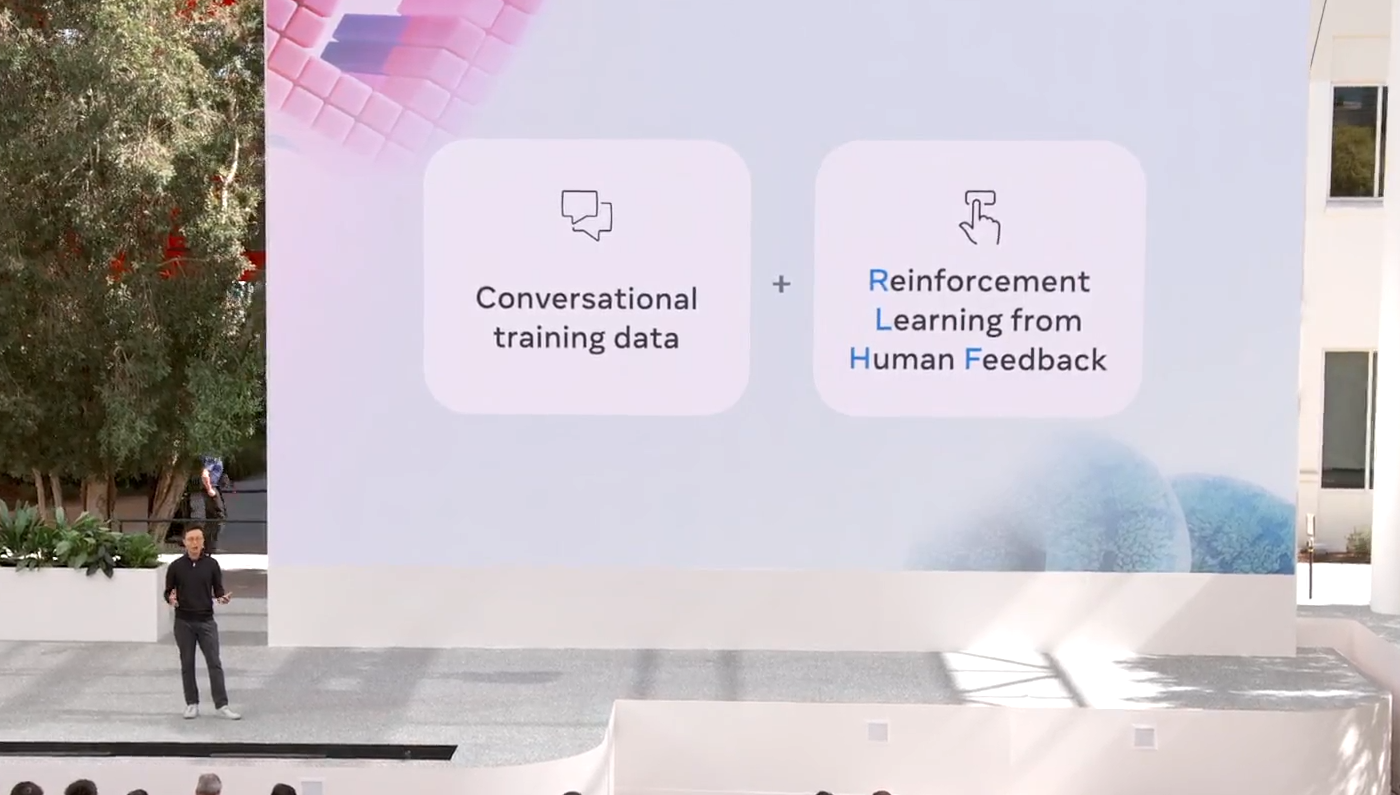

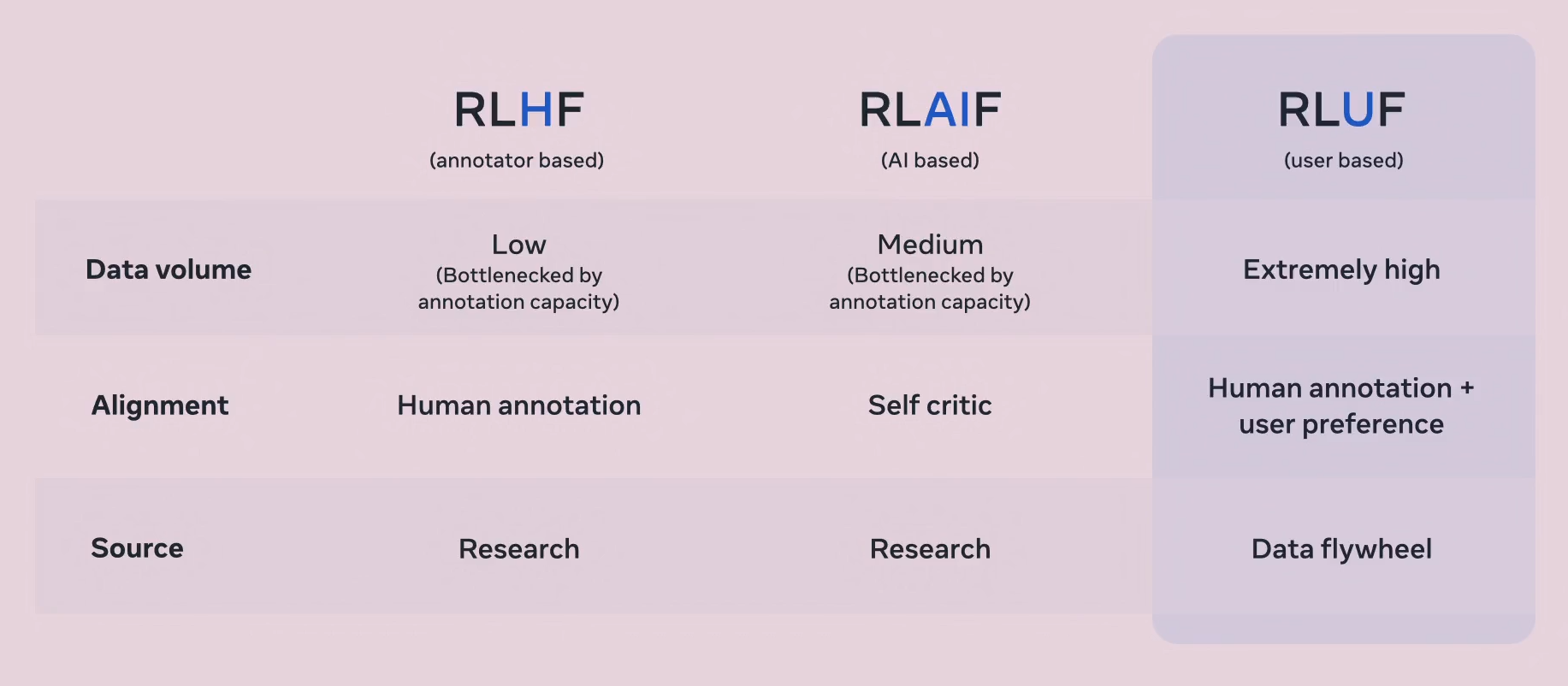

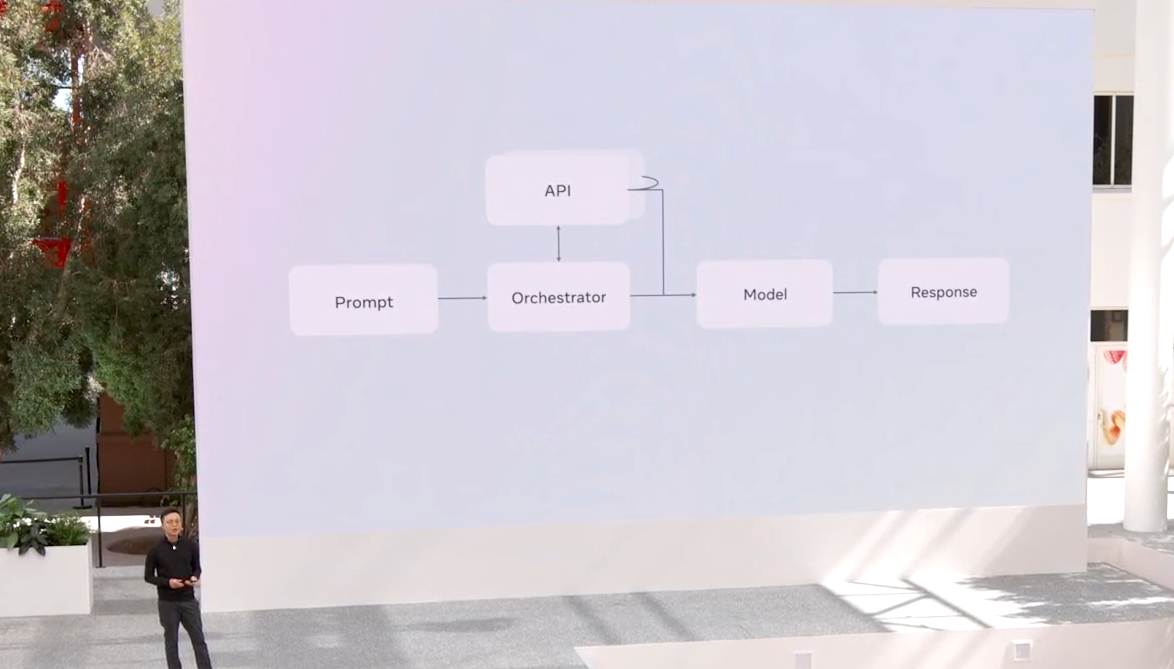

対話を想定してシミュレーションしたデータと、RLHF(Reinforcement Learning from Human Feedback) という人からのフィードバックによる学習強化 という二つの軸で「ナチュラルな対話」を実現する試みだそうです。

この自然なレスポンスに至るまでのプロセスにおいて言語処理の仕組みやデータの料理方法などについて、とても丁寧に説明してくれたのですが、私はデータサイエンティストでもエンジニアでもないので、まるで異世界の魔術講義を聞いてるかのようでした・・・。

分かる方は、きっとスライドを見れば納得されるのでしょうが・・・

とにかく、ナチュラルな対話と噓情報をでっち上げて適当に返さない、ちゃんとレファレンスのある回答をAIに持たせることに成功させたようです!

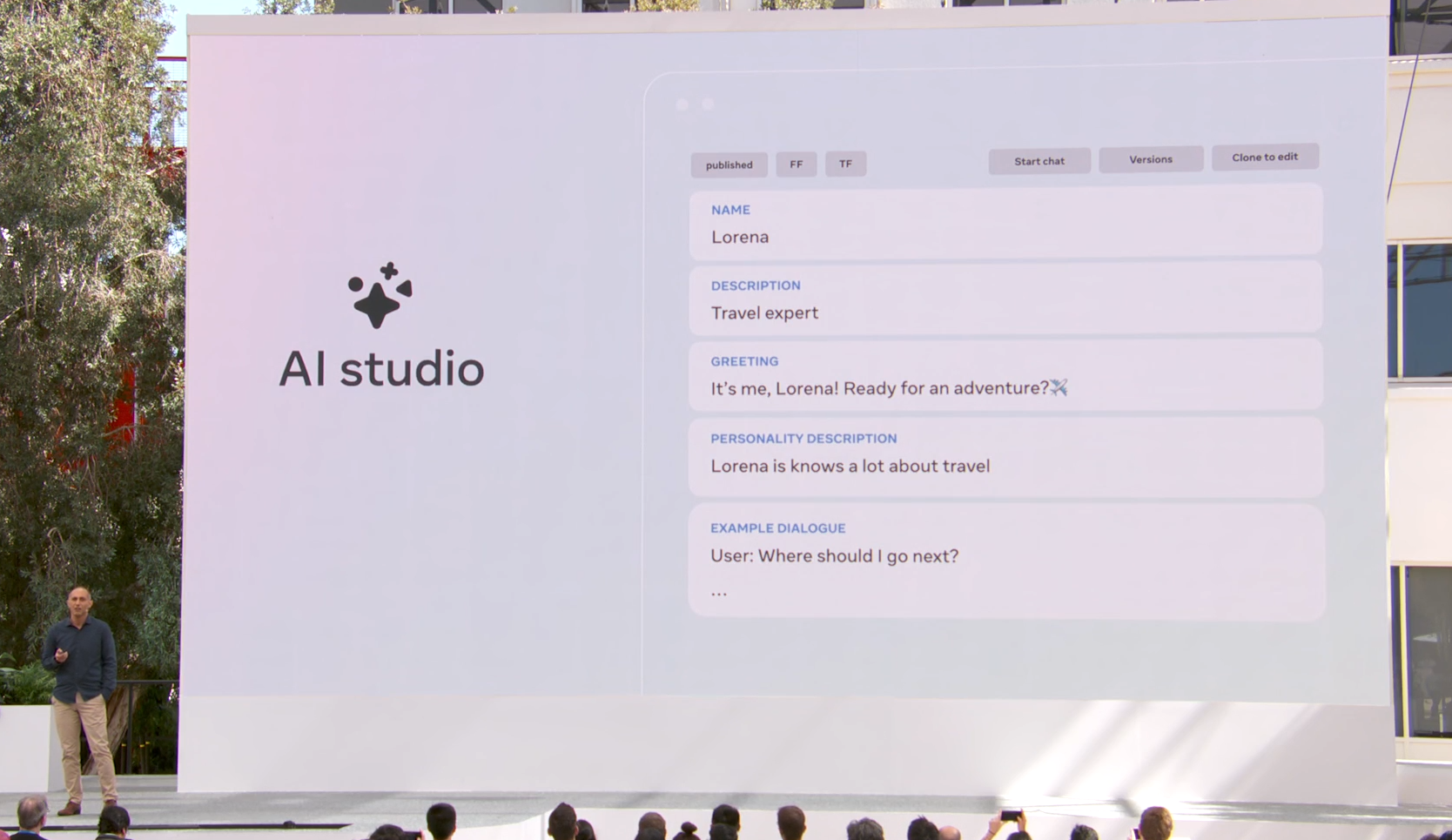

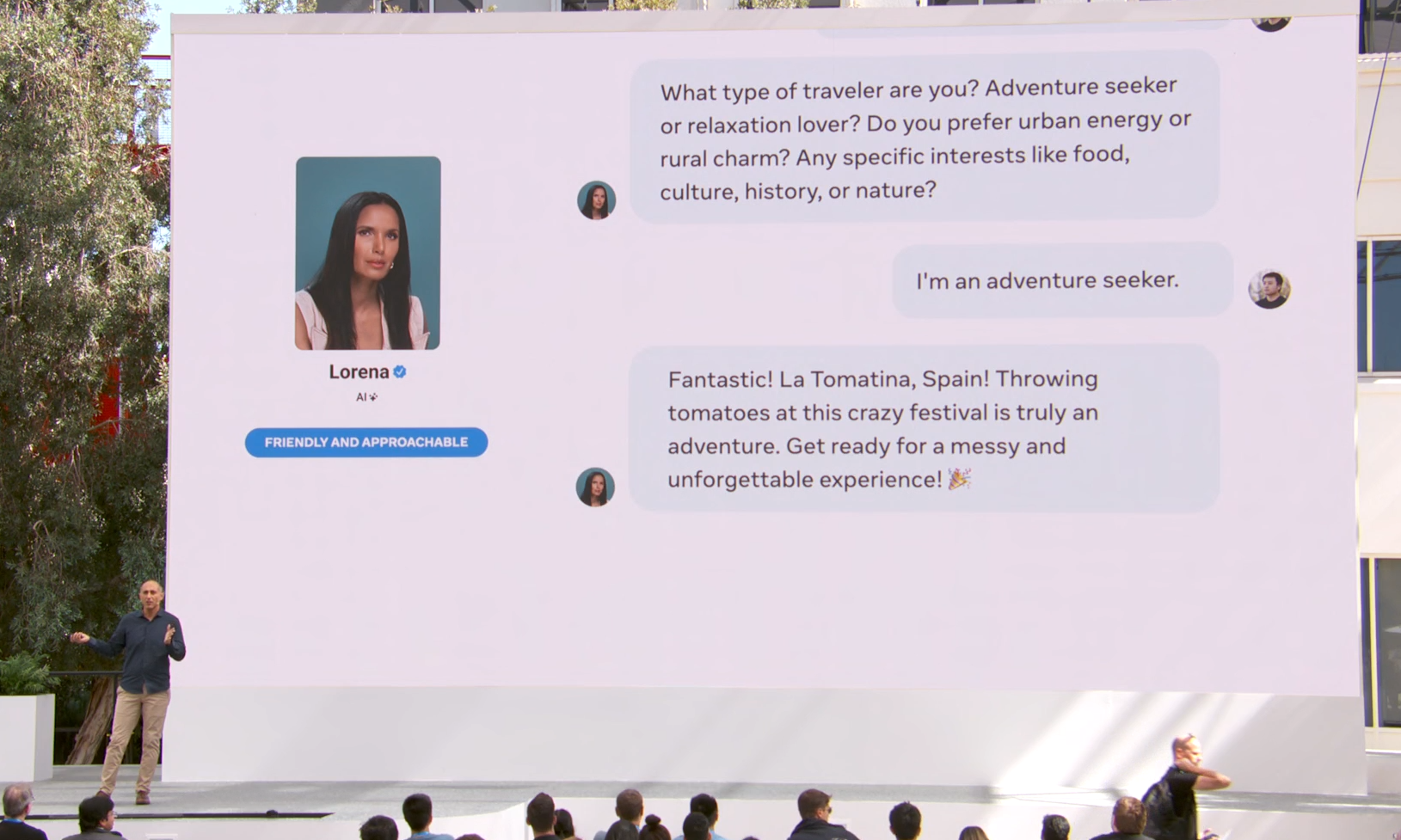

自分好みのAIを創れる AI studio

彼/彼女はどんな会話が得意か、どんな挨拶の仕方ができるか、対話のトーンはどんな感じなのか・・・まるでRPGゲームのNPCをつくるかのようにカスタマイズされたMeta AIキャラクターを生成することができるます。当然、クオリティはMeta AI。

フレンドリーなのか、知識人のような丁寧なのか、キャラクターの個性を一瞬でスワップしていきながら、一番最適なキャラクターを創っていけるそうです。

これにロボット技術が加われば、まさにブレードランナーや攻殻機動隊にみる”AIロボット”ができそうですね・・・!!!

レプリカントのようなディストピアは御免ですが・・・

すでに社会実装されていた!Llameの活用事例

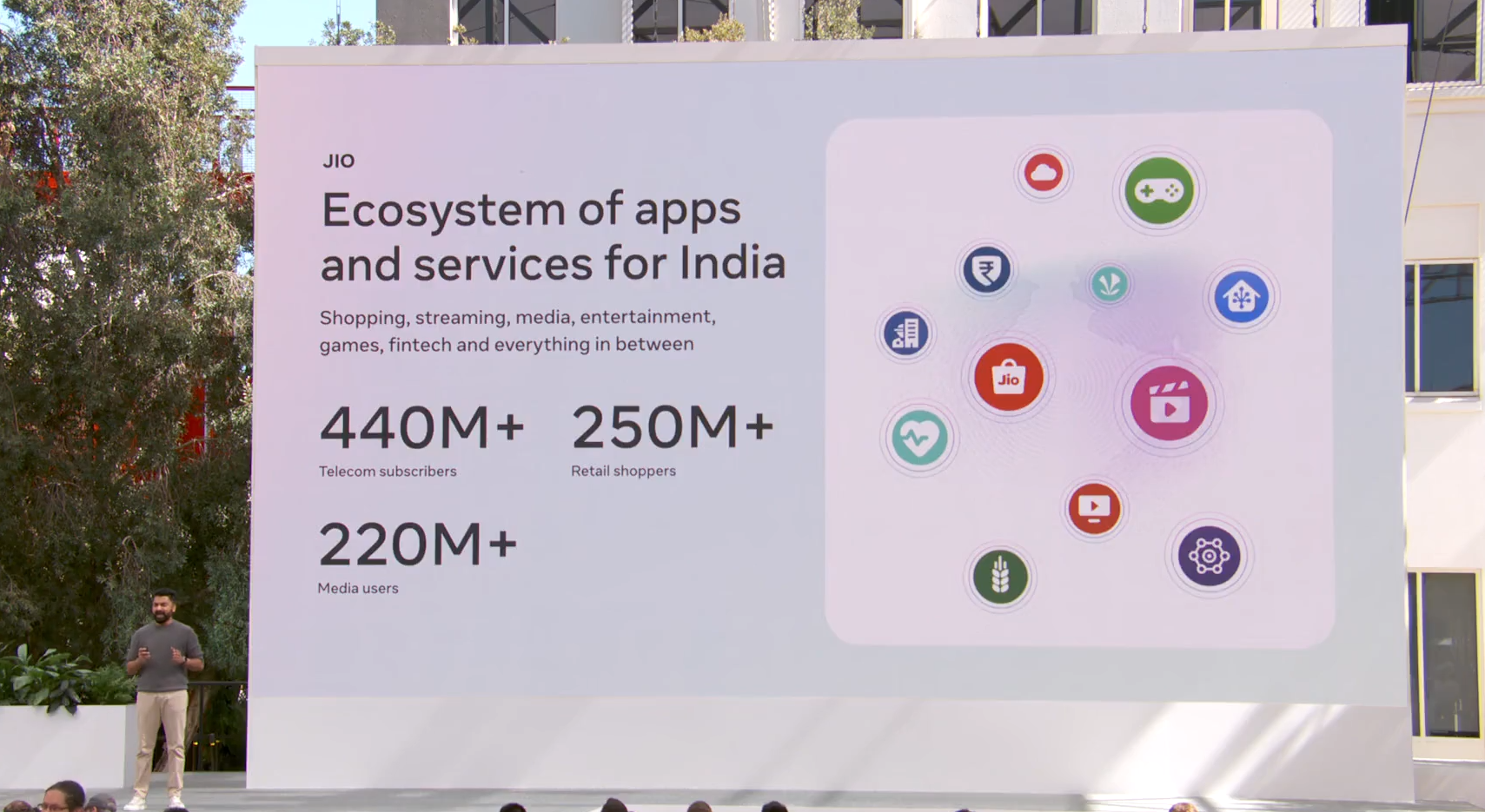

今とってもホットなインドから、Fyndというインド最大のマルチプラットフォーム技術企業がMeta AIの基軸にもなっているLlamaモデルを使用し、JIOというアプリをリリースしました。

これは日本ではあまり見られないタイプのマルチプラットフォームアプリで

例えるならAmazon, Netflix, YouTube, Yahooニュース, ゲームなどが一つのアプリに集約されています。

こういったアプリは海外ではよく見られるのかなと個人的には感じました。

インドネシアにもGrabというアプリがあって、ショッピングができて、タクシーやウーバー的なものも呼べる、便利なアプリです。

アフリカにも同様のアプリがありましたが、名前を忘れました・・・

そのアプリ内で、ユーザーアクションをサポートするAI “JIO COPILOT”が実装されるようです。

マーベル作品が好きな方はご存じアイアンマンに登場するアシスタントAI、ジャービスみたいなものだと思います。

サジェスチョンをするだけでなく、見たいもの、ほしいものなどを伝えることで、適切な回答や商品・サービスを案内してくれるというもの。

さすがはテック大国のインドですね。

まだデモの段階ですが、スピーディーに新しい技術を取り入れてアップグレードしていく・・・。このしなやかさは見習いたいところです。

まとめ

以上、2日目のレポートでした!

今回は1日目と違って、技術開発のプロセスやアップグレードされた内容が専門的で、ハイカロリーでとてもボリューム感のある2時間でした・・・!

私ももう情報の多さにパンクしそうです!英語だし!

しかしながら、Metaが”メタバース”世界の構築に向けて着実に、世界を巻き込んで進ませていることがよくわかりました。

Metaという社名にもあるように、Metaは私たちの生活空間にデジタルがネイティブで存在し、自在に扱ってより便利で快適な世界観を目指しています。

その実現に向けて、一歩進んでいるなという感触を肌で感じたような2日間だったと思います。

メタクエスト3やスマートグラス、ほしいですね!

以上、2日目のレポートでした!

サービスのご紹介

ビーライズは、非接触のバーチャルイベント、仮想空間での次世代型トレーニング、今までにない体験コンテンツなど、「デジタルならではの体験」を開発・実装しています。サービスの詳細や弊社の会社案内についてはこちらからダウンロードください。

資料のダウンロードはこちらPROFILE

- 株式会社 ビーライズBeRISE

- 株式会社ビーライズは、「デジタルで明日を変えよう」をビジョンにかかげ、XR領域でバーチャルワールド活用サービスを提供するテクノロジーカンパニーです。リアルな3DCGとアプリケーション・web開発、アイデアを組み合わせた最先端ソリューション開発を強みとしています。